Le Big Data est l’un des nombreux concepts qui ont pris de la force dans le monde technologique ces dernières années, et c’est simplement un grand volume de données numériques provenant de différentes sources .

Plan de l'article

Qu’est-ce que le Big Data

Le Big Data n’est pas une technologie spécifique, mais est lié à d’autres technologies liées à l’information numérique. Pour approfondir le terme, il est conseillé d’introduire d’abord certains concepts technologiques liés au traitement des données.

Types de données

En tant que « données », nous comprendrons toute information pertinente pour l’entreprise. Pour le reste de l’article, nous supposerons que ces données sont numériques, bien qu’en réalité ce ne soit pas toujours le cas.

Donnéesstructuré

Il s’agit des données qui font partie d’une structure prédéfinie. Par exemple, une feuille Excel ou une base de données SQL. Ces données sont facilement cataloguables et peuvent être utilisées pour des analyses ultérieures et des prévisions fiables.

Données non structurées

Ce sont les données qui n’ont pas ou font partie d’une structure définie. Les exemples incluent le corps d’un e-mail, une conversation Skype, des données écrites dans un fichier Word ou même des bases de données NoSQL. Ces données contiennent beaucoup d’informations précieuses, mais parce qu’elles ne sont pas bien structurées et cataloguées, elles sont difficiles à utiliser lorsqu’il s’agit de rapports et d’analyses. Les dernières tendances de l’Intelligence Artificielle, en particulier les algorithmes de Machine Learning , envisagent leanalyse des données non structurées dans le but d’obtenir des conclusions fiables ; il s’agit d’un domaine complexe et évolutif, mais avec un avenir très prometteur.

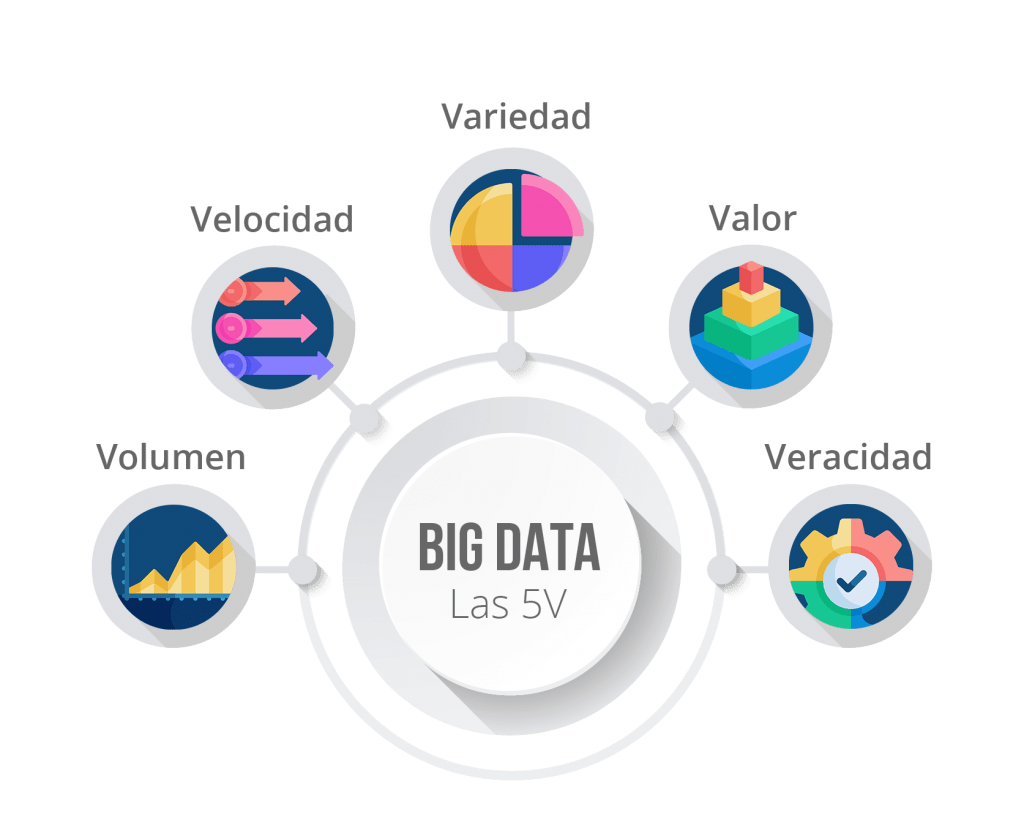

Les 5 « V » du Big Data

Big Data se caractérise par le respect des 5 « V », qui ne sont que 5 caractéristiques représentatives de cette technologie.

Volume

L’une des caractéristiques du Big Data est que les nouvelles données sont constamment générées. De plus, étant donné que les sources sont diverses, le volume des données tend à être immense.

Vitesse

Non seulement il génère beaucoup de données et de nombreuses sources, il est normal que le taux de production de ces données soit très élevé. Cela provoque un flux de données très difficile à gérer avec les logiciels traditionnels.

Variété

DebiOutre la nature unificatrice du Big Data, les informations provenant de sources très différentes doivent être gérées. Cela signifie que même étant des données structurées, une telle structure est différente dans chaque source, ce qui est un nouveau défi pour l’entreprise à résoudre.

Valeur

En raison de l’énorme quantité de données à traiter, il faut prendre un soin particulier dans le choix des données qui sont vraiment importantes pour l’entreprise et ses futures opérations. Une bonne définition des objectifs et une stratégie de pré-stockage permettra d’économiser beaucoup de temps informatique et de faciliter la gestion à long terme.

Véracité

Le Big Data doit être alimenté avec des données pertinentes et vraies. Nous ne serons pas en mesure d’effectuer des analyses utiles si la plupart des données entrantes proviennent de fausses sources ou d’erreurs dans vos informations.

Stockage des données

Sur site

Ce terme est utilisé pour désigner installations logicielles et matérielles locales (serveurs, racks, systèmes de stockage…). Il est dit qu’une entreprise dispose d’une installation sur site lorsqu’elle s’occupe elle-même de l’infrastructure, de la gestion des logiciels et des données.

Nuage

Le terme cloud est utilisé pour désigner l’utilisation d’infrastructure tierce (matériel et logiciel) pour le stockage, la gestion et le traitement des données et des applications. Le cloud, souvent appelé « cloud computing », est généralement un modèle de location ou de paiement à l’utilisation, et certaines des principales entreprises dans ce secteur sont Microsoft, Amazon ou Google.

Le Cloud Computing n’est pas seulement infraestr, mais aussi un ensemble de services informatiques qui permet à toute entreprise d’installer ses différentes solutions logicielles, de les maintenir, d’analyser leurs performances, de les mettre à l’échelle, d’effectuer des sauvegardes et bien plus encore.

Entrepôt de données

Un entrepôt de données est un dépôt de données qui stocke des informations provenant de diverses sources et des systèmes de l’entreprise. Ces entrepôts de données se distinguent par leur grande capacité et offrent un accès optimal aux données, qu’ils soient sur site ou dans le cloud.

Traitement des données

Comme mentionné précédemment, l’objectif du Big Data est d’unifier le stockage et le traitement de différentes sources de données dans le but d’effectuer diverses analyses des données avec tles informations de la société. Pour le traitement correct des données, vous devez passer par 3 phases connues sous le nom ETL (« extraire, transformer, charger »).

Extraction

Cette phase consiste à centraliser la saisie de données à partir de diverses sources.

Transformation

Cette phase tente de normaliser les différents ensembles de données dans le but d’avoir une structure similaire à la sortie. C’est une étape complexe qui nécessitera un code personnalisé basé sur nos données. Cette phase est également connue sous le nom de nettoyage des données.

Charger ou charger

Le « Charger » ou « Charger » consiste en le stockage de données dans un entrepôt de données (Data Warehouse) pour une analyse plus approfondie.

<img src="https://www.auraportal.com/wp-content/uploads/2020/01/generacion-extraccion-analisis-de-datos-cta-1024×272.png" alt="Generaci